大数据处理的基本概念与技术架构

大数据处理是指对超出传统数据库处理能力的海量、高速、多样化数据进行采集、存储、管理和分析的技术体系。其核心特征通常被概括为"4V":Volume(大量)、Velocity(高速)、Variety(多样)和Veracity(真实性)。现代大数据处理架构通常采用分布式计算框架,如Hadoop生态系统,它包含HDFS分布式文件系统、MapReduce计算模型和YARN资源管理器。Spark作为内存计算框架,因其出色的实时处理能力而广受欢迎。NoSQL数据库如MongoDB、Cassandra等解决了传统关系型数据库在处理非结构化数据时的局限性。

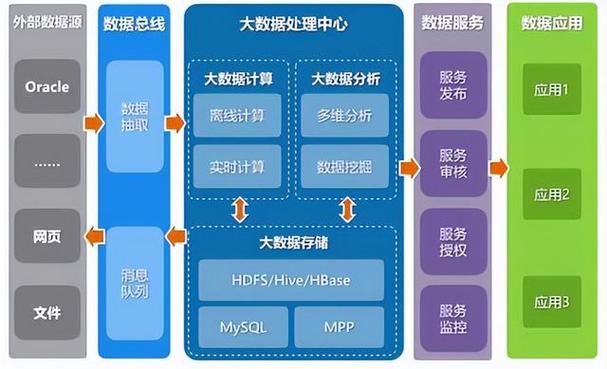

大数据处理的关键技术流程

大数据处理流程通常包括数据采集、数据存储、数据处理和数据分析四个主要环节。在数据采集阶段,需要运用ETL(提取、转换、加载)工具和实时流处理技术。数据存储环节需要考虑分布式文件系统、列式存储等解决方案。数据处理阶段涉及批处理和流处理两种模式,分别适用于不同时效性要求的场景。数据分析则包括描述性分析、预测性分析和规范性分析三个层次。机器学习算法如聚类、分类和回归分析在大数据处理中扮演着越来越重要的角色。数据可视化技术如Tableau、Power BI等工具帮助将复杂的数据分析结果直观呈现。

大数据处理在各行业的应用实践

在金融领域,大数据处理被广泛应用于反欺诈、信用评分和个性化推荐。银行通过分析客户交易行为、社交网络等多维数据,构建更精确的风险评估模型。信用卡公司利用实时流处理技术检测异常交易,防范欺诈行为。投资机构运用自然语言处理技术分析新闻舆情,辅助量化交易决策。

医疗行业通过处理基因组数据、电子病历和穿戴设备采集的健康数据,实现疾病预测和个性化治疗方案。疫情期间,大数据处理在疫情监测、传播预测和疫苗研发中发挥了关键作用。医院运用数据挖掘技术优化资源配置,减少患者等待时间。

大数据处理面临的挑战与解决方案

数据质量问题是大数据处理的首要挑战,需要通过数据清洗、标准化和验证流程来解决。隐私保护与数据安全是另一个关键问题,差分隐私、同态加密等技术的应用日益重要。计算资源消耗巨大,促使企业采用云计算和边缘计算相结合的混合架构。人才短缺问题需要通过系统培训和校企合作来缓解。算法偏见和伦理问题也需要在数据处理流程中得到充分重视。

大数据处理的未来发展趋势

人工智能与大数据的融合将推动自动化机器学习(AutoML)的发展,降低数据分析门槛。边缘计算的普及将实现数据的就近处理,减少传输延迟。量子计算的突破可能彻底改变大数据处理的速度和规模。数据编织(Data Fabric)概念的出现,旨在构建更灵活、智能的数据集成架构。随着5G技术的普及,实时大数据处理能力将得到质的飞跃。

大数据处理技术正在深刻改变我们的工作和生活方式。从基础架构到应用实践,从当前挑战到未来趋势,掌握大数据处理能力已成为数字化转型的关键。企业需要根据自身需求,构建合适的大数据处理体系,培养数据思维,才能在数据驱动的未来保持竞争优势。常见问题解答

大数据处理针对海量、高速、多样化数据,采用分布式架构和新型数据库技术,而传统数据处理主要面向结构化数据,使用关系型数据库和集中式处理。

需考虑数据规模、时效性要求、预算和团队技能。小型项目可从单机版Spark开始,大型企业可能需要完整的Hadoop生态系统结合云服务。

实施数据分类分级、访问控制、加密传输存储、定期审计等措施,同时遵守相关法律法规如GDPR等。

理解业务需求,明确分析目标,学习基础数据知识,与技术人员保持良好沟通,关注数据可视化结果的业务含义。

从几周到数月不等,取决于数据规模、复杂度和技术成熟度。建议采用敏捷方法,分阶段实施,快速验证价值。