什么是数据投毒?

数据投毒是指攻击者故意向机器学习系统的训练数据中注入恶意样本,从而影响模型训练过程和最终决策的一种攻击方式。与传统的网络攻击不同,数据投毒攻击更加隐蔽,其影响可能在模型部署后很长时间才会显现。

数据投毒的工作原理

数据投毒攻击通常发生在模型训练阶段。攻击者通过以下方式实施攻击:1)直接向训练数据集中添加恶意样本;2)操纵数据收集过程;3)利用API接口注入有毒数据。这些恶意样本会改变模型的决策边界,导致模型在面对特定输入时产生错误输出。

数据投毒的主要特点

数据投毒具有几个显著特点:隐蔽性强、影响持久、攻击成本低但危害大。由于攻击发生在训练阶段,常规的安全检测手段往往难以发现。一旦模型被投毒,除非重新训练,否则其影响会持续存在。

常见的数据投毒攻击类型

根据攻击目标和手法的不同,数据投毒可以分为多种类型,每种类型都有其独特的攻击方式和防御难点。

标签翻转攻击(Label Flipping)

这是最常见的数据投毒方式之一。攻击者不改变数据特征,只修改数据标签。将"猫"的图片标记为"狗",或将垃圾邮件标记为正常邮件。这种攻击会误导模型学习错误的特征-标签映射关系。

特征污染攻击(Feature Contamination)

攻击者向数据样本中添加特定特征或噪声,使模型对这些特征产生过度依赖。在图像识别系统中添加特定水印,或在文本数据中插入特定关键词。

数据投毒的实际案例与危害

近年来,数据投毒攻击在多个领域造成了实际危害,以下是几个典型案例:

如何防范数据投毒攻击?

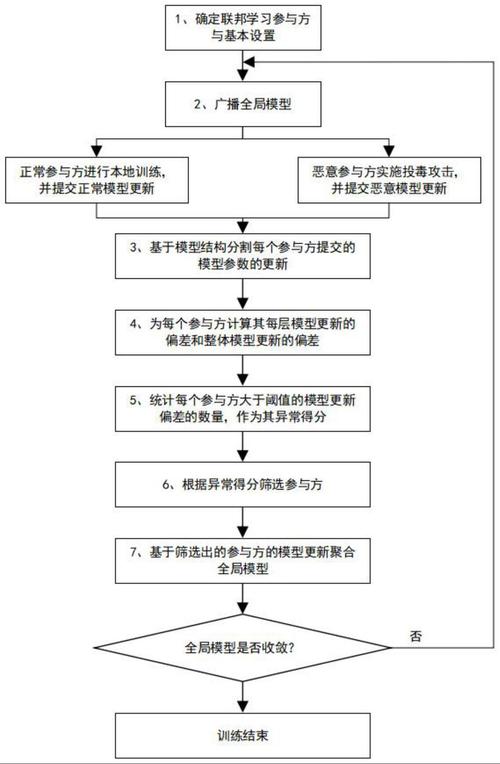

防范数据投毒需要从数据收集、模型训练到部署的全生命周期采取综合措施。

数据清洗与验证

建立严格的数据验证机制,包括:异常值检测、一致性检查、数据来源验证等。使用统计方法和机器学习算法识别可能的恶意样本。

鲁棒性训练技术

采用对抗训练(Adversarial Training

)、差分隐私(Differential Privacy)等技术增强模型的鲁棒性。这些方法可以使模型对训练数据中的噪声和异常值不那么敏感。

模型监控与更新

持续监控模型在生产环境中的表现,建立异常检测机制。定期使用干净数据重新训练模型,及时修复可能存在的漏洞。

数据投毒是AI安全领域的重要挑战,随着AI应用的普及,其威胁将日益严重。防范数据投毒需要技术手段和管理措施相结合,从数据源头到模型部署全程把控。只有建立完善的安全防护体系,才能确保AI系统的可靠性和安全性。

常见问题解答

1. 数据投毒和对抗样本攻击有什么区别?

数据投毒发生在模型训练阶段,通过污染训练数据影响模型;而对抗样本攻击发生在模型部署后,通过精心构造的输入欺骗已经训练好的模型。

2. 如何检测我的模型是否遭到了数据投毒?

可以通过以下方法检测:1)在干净测试集上评估模型性能;2)分析模型对特定输入的敏感性;3)检查训练数据中的异常样本。

3. 中小企业如何防范数据投毒攻击?

中小企业可以采取以下措施:1)使用经过验证的第三方数据集;2)实施基本的数据清洗;3)选择具有内置安全机制的机器学习平台;4)定期监控模型表现。