联邦学习安全的核心技术

联邦学习安全体系建立在多项隐私保护技术之上,这些技术共同构成了联邦学习的安全屏障。同态加密技术允许在加密数据上直接进行计算,确保原始数据不会被泄露。差分隐私技术通过添加精心设计的噪声,使得从模型参数中推断个体数据变得极其困难。安全多方计算技术使得多个参与方可以在不泄露各自私有数据的情况下共同完成计算任务。

1.1 同态加密在联邦学习中的应用

同态加密是联邦学习安全的重要保障,它允许服务器在不解密客户端数据的情况下执行聚合操作。目前广泛使用的Paillier半同态加密方案,支持加法同态运算,非常适合联邦学习中的模型参数聚合。全同态加密虽然功能更强大,但计算开销较大,在实际应用中需要权衡安全性和效率。

1.2 差分隐私的保护机制

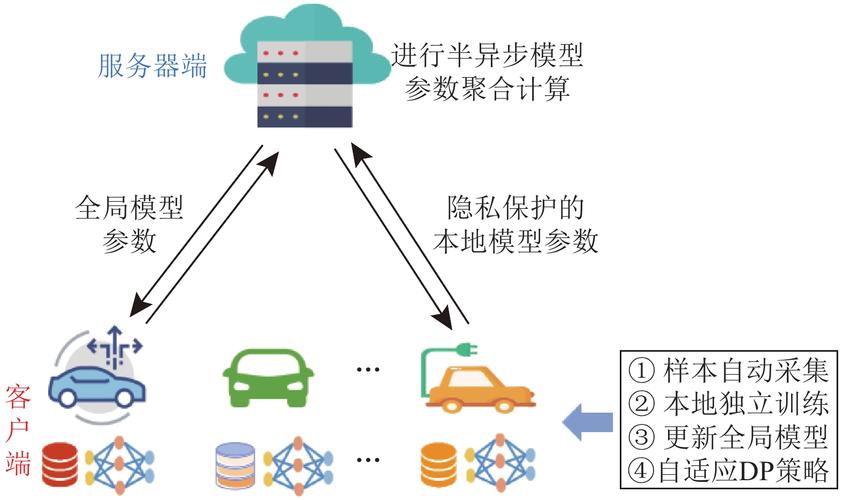

差分隐私通过向模型参数或梯度添加随机噪声,确保外部攻击者无法确定特定个体是否参与了训练。在联邦学习中,可以在客户端本地实施差分隐私保护,也可以在服务器端聚合时添加噪声。关键挑战在于平衡隐私保护强度和模型性能,这需要精心设计噪声添加策略和隐私预算分配方案。

联邦学习面临的安全威胁

尽管联邦学习具有天然的隐私保护优势,但仍然面临多种安全威胁,需要采取针对性的防御措施。这些威胁包括模型反演攻击、成员推理攻击、后门攻击等,它们可能泄露敏感数据或破坏模型功能。

2.1 隐私泄露风险分析

研究表明,攻击者可以通过分析模型参数或梯度来重构训练数据,特别是在图像等复杂数据场景下。成员推理攻击则可以判断特定样本是否参与了模型训练,这在医疗等敏感领域尤其危险。防御这些攻击需要结合加密技术、差分隐私和模型设计优化等多种手段。

2.2 恶意参与方攻击

联邦学习的分布式特性使得系统容易受到恶意客户端的攻击。攻击者可能提交伪造的梯度来破坏模型性能,或植入后门使模型在特定条件下产生错误输出。针对这类威胁,需要开发鲁棒的聚合算法和客户端验证机制,如基于Krum、Byzantine等算法的防御方案。

联邦学习安全实践指南

在实际应用中实现安全的联邦学习需要综合考虑技术方案、系统架构和管理流程。以下是几个关键实践方向:

常见问题解答

Q1: 联邦学习能否完全避免数据泄露?

A1: 联邦学习大大降低了数据泄露风险,但不能保证绝对安全。需要结合加密、差分隐私等技术构建多层次防御体系,并根据具体应用场景调整安全级别。

Q2: 如何平衡联邦学习的安全性和模型性能?

A2: 这是一个需要权衡的问题。通常可以从隐私预算分配、加密方案选择、聚合算法优化等方面进行调整,找到适合特定场景的最佳平衡点。

Q3: 联邦学习安全未来的发展方向是什么?

A3: 未来研究将集中在更高效的加密方案、自适应隐私保护机制、可验证计算等领域。同时,跨模态联邦学习和联邦学习与区块链的结合也是重要方向。

联邦学习安全是人工智能隐私保护的重要课题,随着技术的不断发展和完善,联邦学习必将在医疗、金融等敏感领域发挥更大价值。通过持续优化安全机制和防御策略,我们可以构建更加可信的分布式机器学习生态系统,实现数据价值挖掘与隐私保护的双赢。