在当今快速发展的技术环境中,GPT应用在Linux服务器上的部署已成为许多企业和开发者的关键需求。本文将为您提供一份详细的GPT应用部署指南,帮助您在Linux服务器上顺利部署并运行GPT应用。

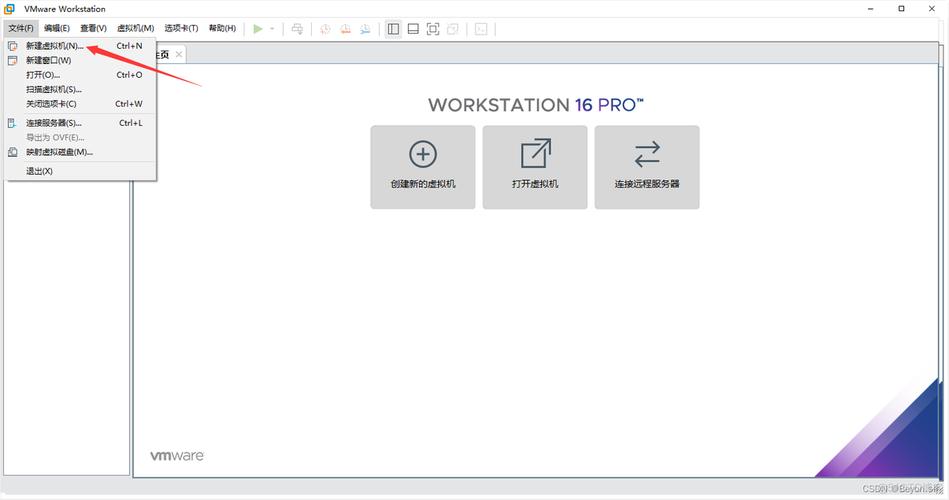

一、准备工作

(图片来源网络,侵删)

在开始部署之前,您需要确保Linux服务器满足以下条件:

- 安装了Python环境(建议Python 3.6以上版本)

- 安装了pip包管理工具

- 安装了必要的依赖库,如numpy、torch等

二、安装GPT模型

以下是安装GPT模型的具体步骤:

- 从Hugging Face网站下载GPT模型文件。

- 解压模型文件到指定目录。

- 使用pip安装transformers库,以便使用GPT模型。

三、部署GPT应用

部署GPT应用的步骤如下:

1. 创建项目目录

在服务器上创建一个项目目录,用于存放GPT应用的所有文件。

2. 编写应用代码

编写GPT应用的代码,包括加载模型、处理输入文本、生成输出文本等功能。

3. 部署应用

将编写好的代码部署到服务器上,确保应用能够正常运行。

四、测试与优化

部署完成后,您需要对GPT应用进行测试,确保其能够正确响应输入并生成高质量的文本。根据测试结果,您可能需要对应用进行优化,以提高性能和用户体验。

五、常见问题解答

- Q:如何确保GPT模型的安全性和稳定性?

- A:建议定期更新模型和依赖库,确保使用最新的安全补丁。同时,监控应用的运行状态,及时发现并解决潜在问题。

- Q:GPT应用如何处理大量并发请求?

- A:可以考虑使用负载均衡器分散请求,或者使用异步处理方式来提高并发处理能力。

- Q:如何提高GPT应用的生成质量?

- A:可以尝试调整模型参数、使用更大的模型或者进行微调等手段来提高生成质量。

通过以上步骤,您应该能够在Linux服务器上成功部署GPT应用。记得定期进行维护和优化,以确保应用的稳定性和性能。

文章版权声明:除非注明,否则均为论主机评测网原创文章,转载或复制请以超链接形式并注明出处。